Esta postagem ilustrará o processo de construção de aplicativos LangChain usando Prompt Template e Output Parser.

Como construir aplicativos LangChain usando modelo de prompt e analisador de saída?

Para construir o aplicativo LangChain usando o modelo de prompt e o analisador de saída, basta seguir este guia fácil:

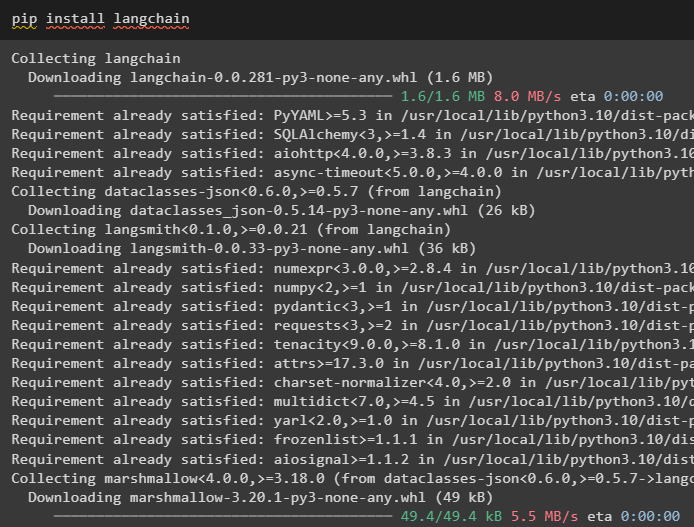

Passo 1: Instalar LangChain

Primeiro, inicie o processo de construção de aplicativos LangChain instalando a estrutura LangChain usando o “ pip ”comando:

pip instalar langchain

Etapa 2: usando o modelo de prompt

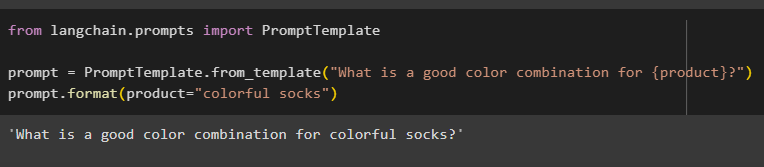

Após instalar os módulos LangChain, importe o “ Modelo de prompt ”biblioteca para construir um modelo de prompt, fornecendo uma consulta para o modelo entender a pergunta:

de langchain.prompts importar PromptTemplate

prompt = PromptTemplate.from_template('Qual é uma boa combinação de cores para {produto}?')

prompt.format(product='meias coloridas')

A saída combinou automaticamente a frase com o valor de “ produtos ' variável:

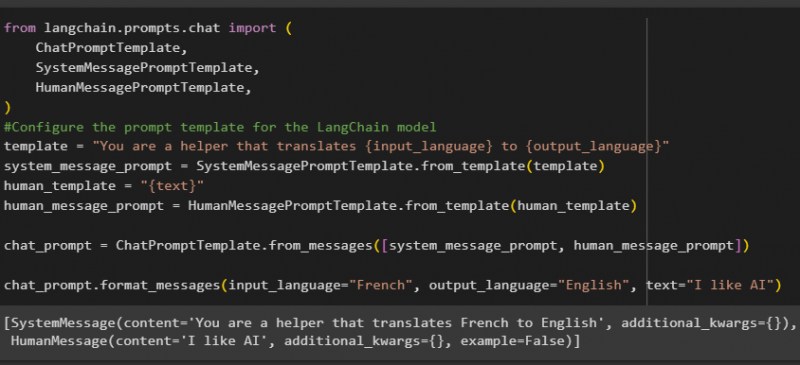

Depois disso, crie outro modelo de prompt importando as bibliotecas HumanMessagePromptTemplate, ChatPromptTemplate e SystemMessagePromptTemplate do LangChain:

de importação langchain.prompts.chat (Modelo de prompt de bate-papo,

SystemMessagePromptTemplate,

HumanMessagePromptTemplate,

)

#Configure o modelo de prompt para o modelo LangChain

template = 'Você é um ajudante que traduz {input_linguagem} para {output_idioma}'

system_message_prompt = SystemMessagePromptTemplate.from_template(modelo)

human_template = '{texto}'

human_message_prompt = HumanMessagePromptTemplate.from_template(human_template)

chat_prompt = ChatPromptTemplate.from_messages([system_message_prompt, human_message_prompt])

chat_prompt.format_messages(input_idioma='Francês', output_idioma='Inglês', text='Gosto de IA')

Após importar todas as bibliotecas necessárias, basta construir o modelo personalizado para as consultas usando a variável de modelo:

Os modelos de prompt são usados apenas para definir o modelo para a consulta/pergunta e não respondem à pergunta. No entanto, a função OutputParser() pode extrair respostas conforme explicado na seção a seguir com o exemplo:

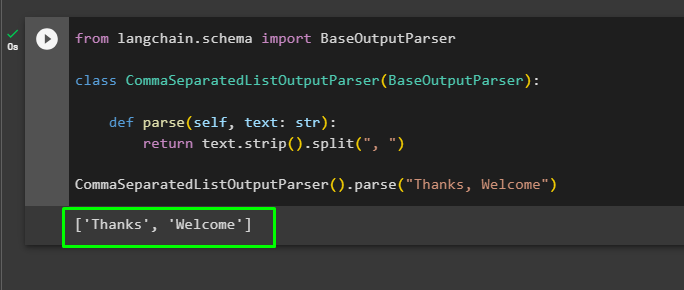

Etapa 3: usando o analisador de saída

Agora, importe a biblioteca BaseOutputParser do LangChain para separar os valores do texto separados por vírgulas e retornar a lista na saída:

de langchain.schema importar BaseOutputParserclasse CommaSeparatedListOutputParser (BaseOutputParser):

def analisar(self, texto: str):

retornar texto.strip().split(', ')

CommaSeparatedListOutputParser().parse('Obrigado, bem-vindo')

Trata-se de construir o aplicativo LangChain usando o modelo de prompt e o analisador de saída.

Conclusão

Para construir um aplicativo LangChain usando o modelo de prompt e o analisador de saída, basta instalar o LangChain e importar bibliotecas dele. A biblioteca PromptTemplate é usada para construir a estrutura da consulta para que o modelo possa entender a questão antes de extrair informações usando a função Parser(). A função OutputParser() é usada para buscar respostas com base nas consultas customizadas anteriormente. Este guia explicou o processo de construção de aplicativos LangChain usando o modelo de prompt e o analisador de saída.