LangChain é a estrutura que contém múltiplas dependências e bibliotecas que podem ser usadas para construir grandes modelos de linguagem. Esses modelos podem ser usados para interagir com humanos, mas primeiro, o modelo deve aprender como obter/entender a solicitação/pergunta feita pelo humano. Para isso, o modelo precisa ser treinado nos templates de prompt e então o usuário faz a pergunta dentro do template fornecido.

Este guia ilustrará o processo de construção de modelos de prompt no LangChain.

Como construir modelos de prompt no LangChain?

Para construir modelos de prompt no LangChain, basta seguir o seguinte guia com várias etapas:

Etapa 1: Instalar Módulos e Ambiente de Configuração

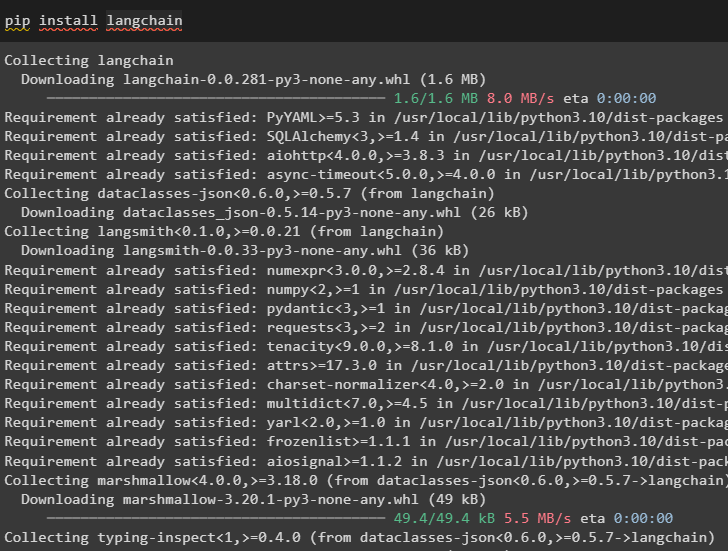

Inicie o processo de construção de modelos de prompt no LangChain instalando a estrutura LangChain:

pip instalar langchain

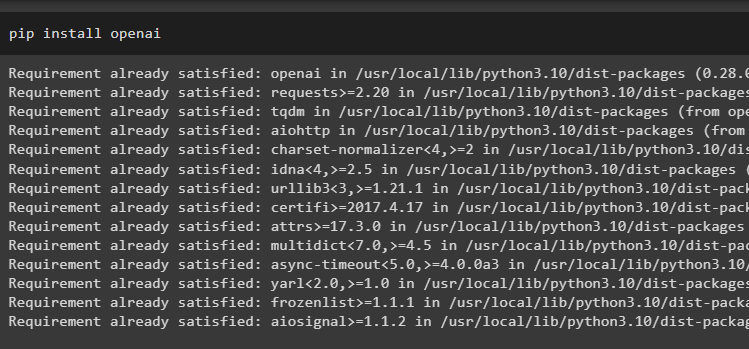

Agora, instale os módulos OpenAI para acessar suas bibliotecas e definir um ambiente usando-os:

pip instalar openai

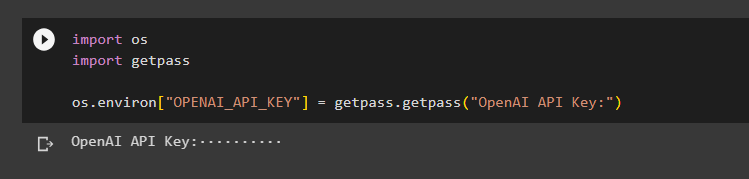

Configure o Ambiente OpenAI usando a biblioteca os para acessar o sistema operacional e fornecer a chave da API OpenAI:

importe-nosimportar getpass

os.environ['OPENAI_API_KEY'] = getpass.getpass('Chave de API OpenAI:')

Etapa 2: usando o modelo de prompt

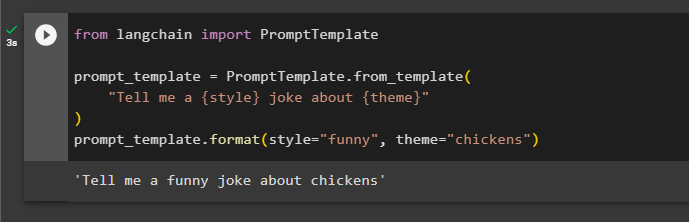

Após instalar o LangChain, basta importar a biblioteca PromptTemplate e construir um template para a consulta sobre uma piada com alguns aspectos extras como variáveis como adjetivo, conteúdo, etc.:

do PromptTemplate de importação de langchainprompt_template=PromptTemplate.from_template(

'Conte-me uma piada de {estilo} sobre {tema}'

)

prompt_template.format(style='engraçado', tema='galinhas')

O prompt foi definido e entregue ao modelo com os valores da variável inserida no comando:

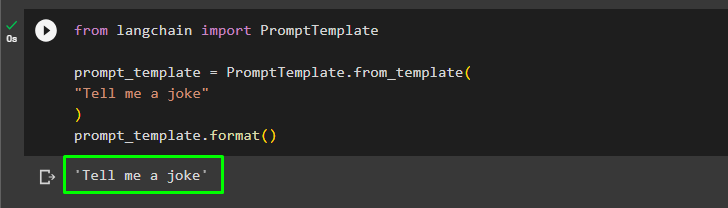

O usuário pode personalizar o modelo de prompt com uma consulta simples pedindo uma piada:

do PromptTemplate de importação de langchainprompt_template=PromptTemplate.from_template(

'Conte-me uma piada'

)

prompt_template.format()

O método acima serve para uma única consulta e resposta, mas às vezes o usuário deseja interagir com o modelo na forma de chat e a próxima seção explica seu formato.

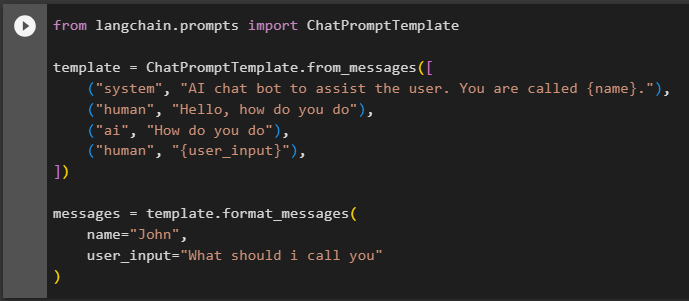

Etapa 3: usando o modelo de prompt de bate-papo

Esta seção explica o modelo para um modelo de bate-papo baseado em um padrão de conversação, como dois humanos interagindo entre si:

de langchain.prompts importar ChatPromptTemplatemodelo = ChatPromptTemplate.from_messages([

('sistema', 'Bot de bate-papo AI para ajudar o usuário. Seu nome é {nome}.'),

('humano', 'Olá, como vai'),

('ai', 'Como vai'),

('humano', '{user_input}'),

])

mensagens = template.format_messages(

nome='João',

user_input = 'Como devo ligar para você'

)

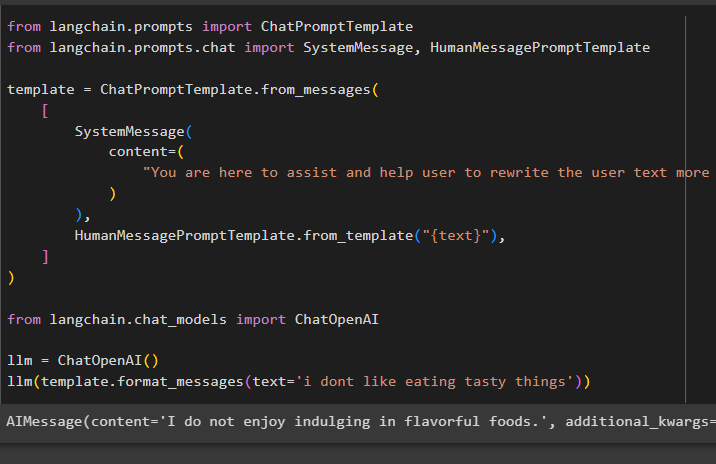

Após definir a estrutura do template, basta escrever algumas linhas no texto para dizer ao modelo o que se espera dele e usar a função llm() para dar um prompt:

de langchain.prompts importar ChatPromptTemplatede langchain.prompts.chat importar SystemMessage, HumanMessagePromptTemplate

modelo = ChatPromptTemplate.from_messages(

[

Mensagem do sistema(

conteúdo=(

'Você está aqui para auxiliar e ajudar o usuário a reescrever o texto do usuário de forma mais eficaz'

)

),

HumanMessagePromptTemplate.from_template('{texto}'),

]

)

de langchain.chat_models importar ChatOpenAI

llm = ChatOpenAI()

llm(template.format_messages(text='não gosto de comer coisas saborosas'))

O método SystemMessage() contém o conteúdo da resposta para a consulta usada no LLM:

Trata-se de construir modelos de prompt no LangChain.

Conclusão

Para construir um modelo de prompt no LangChain, basta instalar os módulos LangChain e OpenAI para configurar um ambiente usando a chave API OpenAI. Depois disso, crie um modelo de prompt para um único prompt, como pedir uma piada ou uma única pergunta sobre qualquer coisa. Outro método é personalizar um modelo de chat baseado no processo de interação entre dois humanos diferentes. Esta postagem ilustrou o processo de construção de um modelo de prompt no LangChain.