Sintaxe:

Como conhecemos o ChatGPT, sabemos que esta plataforma pertence à comunidade Open AI e fornece ferramentas, arquiteturas, APIs e vários frameworks que podemos utilizar na implantação de nossos aplicativos e nos modelos de processamento de linguagem natural. O Open AI oferece as APIs por meio das quais podemos usar qualquer modelo pré-treinado de AI e NLP da plataforma Open AI e podemos fazê-los funcionar para nossos aplicativos, como, por exemplo, fornecer previsões sobre dados em tempo real. Da mesma forma, o GPT4All também permite que seus usuários integrem seus modelos de IA pré-treinados com diferentes aplicativos.

O modelo GPT4All é treinado em dados limitados em comparação com o ChatGPT. Ele também tem algumas de suas restrições de desempenho em comparação com o ChatGPT, mas permite que o usuário use seu GPT privado em seu hardware local e não requer nenhuma conexão de rede. Com a ajuda deste artigo, saberemos como podemos usar os modelos GPT4All no script Python, pois o GPT4All possui as ligações oficiais com o Python, o que significa que também podemos usar e integrar os modelos GPT4All através do script Python.

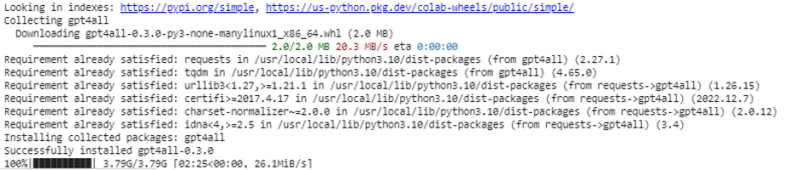

Tudo leva um comando online para instalar o GPT4All para o Python IDE. Então, podemos integrar tantos modelos de IA quantos forem nossos aplicativos. O comando para instalar este GPT4All em Python é o seguinte:

$ pip instalar gpt4all

Exemplo 1:

Para começar com este exemplo, precisamos baixar e instalar o Python em nossos sistemas. As versões recomendadas do Python são a “versão 3.7” ou as que vieram após esta versão. Outra forma de trabalhar com Python para evitar o longo processo de instalação do “Python setup” em nossos sistemas é utilizando o “Google Colab” que é um ambiente baseado em nuvem para Python. Podemos executar esse ambiente em qualquer navegador da Web e construir os modelos de IA e aprendizado de máquina. Os exemplos que vamos implementar aqui são executados no Google Colab.

Este exemplo aborda o método para instalar o GPT4All em Python e como usar seus modelos pré-treinados. Começamos instalando primeiro o GPT4All. Para isso, o comando que mencionamos anteriormente é executado. Com a execução do comando, o GPT4All juntamente com seus pacotes e frameworks são baixados e instalados.

Agora, avançamos. De GPT4All, importamos o “GPT4All”. Isso adiciona todos os modelos pré-treinados do GPT4All ao projeto. Agora, podemos utilizar qualquer modelo único e fazer com que ele faça as previsões para nossa aplicação. Depois de importar o pacote GPT4All, agora é hora de chamar essa função e usar o modelo GPT4All que fornece a saída para a “conclusão do chat”.

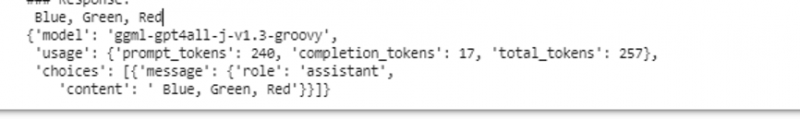

Em outras palavras, se perguntarmos algo desse modelo na entrada, ele retornará na saída. O modelo que usamos aqui é “ggml-gpt4all-j-v1.3-groovy”. Esses modelos já estão armazenados no cache GPT4All. Podemos obter esses modelos neste link “ https://github.com/nomic-ai/gpt4all/tree/main/gpt4all-chat ” para download manual. Se o modelo já estiver presente no cache GPT4All, simplesmente chamamos o nome do modelo e o especificamos como parâmetros de entrada para a função “GPT4All()”. Se o baixamos manualmente com sucesso, passamos o caminho para a pasta onde o modelo está localizado. Como esse modelo é para conclusão de mensagem, a sintaxe desse modelo é fornecida da seguinte forma:

$ Chat_completion (mensagens)As mensagens são uma lista de dicionários e cada dicionário deve conter uma chave de “função” com um valor do usuário, sistema ou assistente, e o conteúdo da “chave” que tem o valor como string. Neste exemplo, especificamos o conteúdo como 'nome três cores' e a chave de função como 'usuário'.

$model= GPT4All('ggml-gpt4all-j-v1.3-groovy')$messages = [{'role': 'user', 'content': 'Nomeie 3 flores'}]

Após esta especificação, chamamos a função “chat_completion()” com o modelo. O código para isso é exibido na seguinte saída:

$ !pip instalar gpt4allde gpt4all importar GPT4All

modelo = GPT4All('ggml-gpt4all-j-v1.3-groovy')

mensagens = [{'role': 'usuário', 'conteúdo': 'Nomeie três cores'}]

model.chat_completion(mensagens)

Após a execução deste exemplo, o modelo retorna três cores como resposta à entrada.

Exemplo 2:

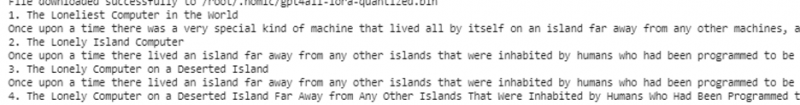

Cobrimos outro exemplo onde descobrimos outro método para usar o GPT4All em Python. Isso pode ser feito usando as ligações oficiais para o Python fornecidas pela “Nomic”, que é uma comunidade de IA de código aberto e executa o GPT4All. Usando o seguinte comando, integramos “nomic” em nosso console Python:

$ pip instalar nomicUma vez instalado, importamos o GPT4All de “nomic.gpt4all”. Após importar o GPT4All, inicializamos o GPT4All com a função “open()”. Em seguida, chamamos a função “prompt()” e passamos um prompt para esta função. Em seguida, uma resposta de prompt é gerada com base no prompt que fornecemos como entrada para o modelo de prompt.

!pip instalar nomicde nomic.gpt4all importar GPT4All

# Inicializa o modelo GPT4All

iniciar = GPT4All()

iniciar.abrir()

# Gerando uma resposta com base no prompt

model_response = initial.prompt('escreva um conto sobre um computador)

# exibindo a resposta gerada

print(model_response)

A saída exibe a resposta do prompt do modelo que geramos usando o modelo GPT4All pré-treinado em Python. Se quisermos saber mais sobre os modelos e como podemos usar esses modelos para gerar as respostas, ou em palavras simples, se quisermos obter conhecimento sobre a sintaxe para gerar as respostas desses modelos, podemos obter mais ajuda do GPT4Todos os detalhes da documentação técnica.

Conclusão

GPT4All ainda está se esforçando para obter precisão de desempenho. É executado pela plataforma nomic AI, que visa fornecer chatbots artificialmente inteligentes para seus usuários nas CPUs de nível de consumidor, já que o GPT4All funciona sem qualquer conexão de rede e GPUs. Este artigo nos ilumina para usar o PyGPT4All com proficiência em um ambiente Python e para criar uma interação entre nossos aplicativos e os modelos GPT4All AI pré-treinados. Cobrimos dois métodos diferentes sobre como instalar o GPT4All em Python neste guia.