Este guia ilustrará o processo de uso do gráfico de conhecimento de conversação no LangChain.

Como usar o gráfico de conhecimento de conversação no LangChain?

O ConversaKGMemory biblioteca pode ser usada para recriar a memória que pode ser usada para obter o contexto da interação. Para aprender o processo de uso do gráfico de conhecimento de conversação no LangChain, basta seguir as etapas listadas:

Etapa 1: instalar módulos

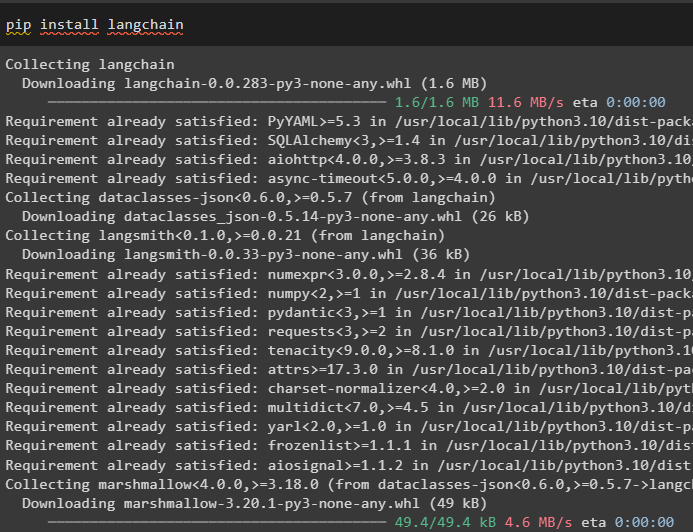

Primeiro, comece o processo de uso do gráfico de conhecimento de conversação instalando o módulo LangChain:

pip instalar langchain

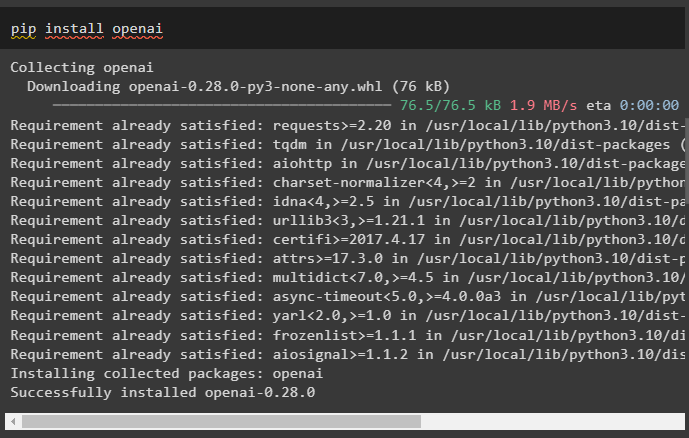

Instale o módulo OpenAI que pode ser instalado usando o comando pip para obter suas bibliotecas para construir modelos de linguagem grandes:

pip instalar openai

Agora, configurar o ambiente usando a chave da API OpenAI que pode ser gerada a partir de sua conta:

importar os

importar Obter passagem

os . aproximadamente [ 'OPENAI_API_KEY' ] = Obter passagem . Obter passagem ( 'Chave de API OpenAI:' )

Etapa 2: usando memória com LLMs

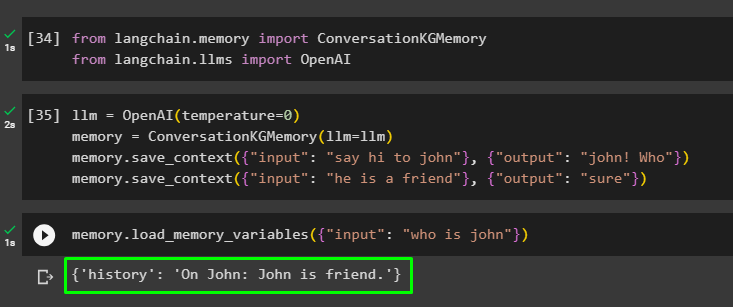

Depois que os módulos estiverem instalados, comece a usar a memória com LLM importando as bibliotecas necessárias do módulo LangChain:

de cadeia longa. memória importar ConversaKGMemoryde cadeia longa. llms importar OpenAI

Construa o LLM usando o método OpenAI() e configure a memória usando o ConversaKGMemory () método. Depois disso, salve os modelos de prompt usando múltiplas entradas com suas respectivas respostas para treinar o modelo nesses dados:

llm = OpenAI ( temperatura = 0 )memória = ConversaKGMemory ( llm = llm )

memória. salvar_contexto ( { 'entrada' : 'diga oi para John' } , { 'saída' : 'João! Quem' } )

memória. salvar_contexto ( { 'entrada' : 'ele é um amigo' } , { 'saída' : 'claro' } )

Teste a memória carregando o variáveis_de_memória () método usando a consulta relacionada aos dados acima:

memória. carregar_memória_variáveis ( { 'entrada' : 'quem e John' } )

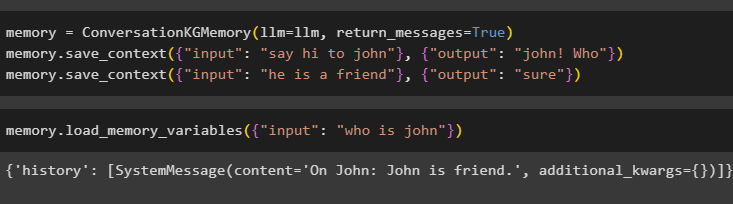

Configure a memória usando o método ConversationKGMemory() com o mensagens_retornadas argumento para obter o histórico da entrada também:

memória = ConversaKGMemory ( llm = llm , mensagens_retornadas = Verdadeiro )memória. salvar_contexto ( { 'entrada' : 'diga oi para John' } , { 'saída' : 'João! Quem' } )

memória. salvar_contexto ( { 'entrada' : 'ele é um amigo' } , { 'saída' : 'claro' } )

Simplesmente teste a memória fornecendo ao argumento de entrada seu valor na forma de uma consulta:

memória. carregar_memória_variáveis ( { 'entrada' : 'quem e John' } )

Agora, teste a memória fazendo a pergunta que não é mencionada nos dados de treinamento, e o modelo não tem ideia da resposta:

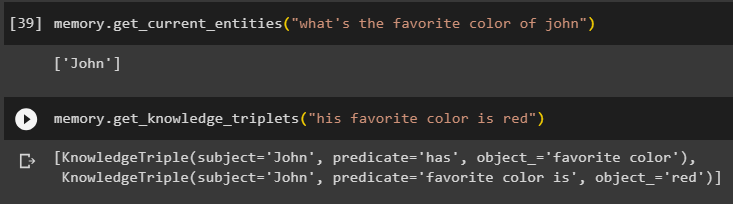

memória. get_current_entities ( 'qual é a cor preferida do João' )Use o get_knowledge_triplets () respondendo à consulta feita anteriormente:

memória. get_knowledge_triplets ( 'sua cor favorita é vermelho' )

Etapa 3: usando memória em cadeia

A próxima etapa utiliza a memória de conversação com as cadeias para construir o modelo LLM usando o método OpenAI(). Depois disso, configure o modelo de prompt usando a estrutura de conversa e o texto será exibido ao obter a saída do modelo:

llm = OpenAI ( temperatura = 0 )de cadeia longa. Comandos . incitar importar Modelo de prompt

de cadeia longa. correntes importar Cadeia de conversação

modelo = '''Este é o modelo para a interação entre humanos e máquinas

O sistema é um modelo de IA que pode falar ou extrair informações sobre vários aspectos

Se não entende a pergunta ou não tem a resposta, simplesmente diz isso

O sistema extrai os dados armazenados na seção 'Específico' e não tem alucinações

Específico:

{história}

Conversação:

Humano: {entrada}

IA:'''

#Configurar o modelo ou estrutura para fornecer prompts e obter resposta do sistema de IA

incitar = Modelo de prompt ( variáveis_de_entrada = [ 'história' , 'entrada' ] , modelo = modelo )

conversa_com_kg = Cadeia de conversação (

llm = llm , detalhado = Verdadeiro , incitar = incitar , memória = ConversaKGMemory ( llm = llm )

)

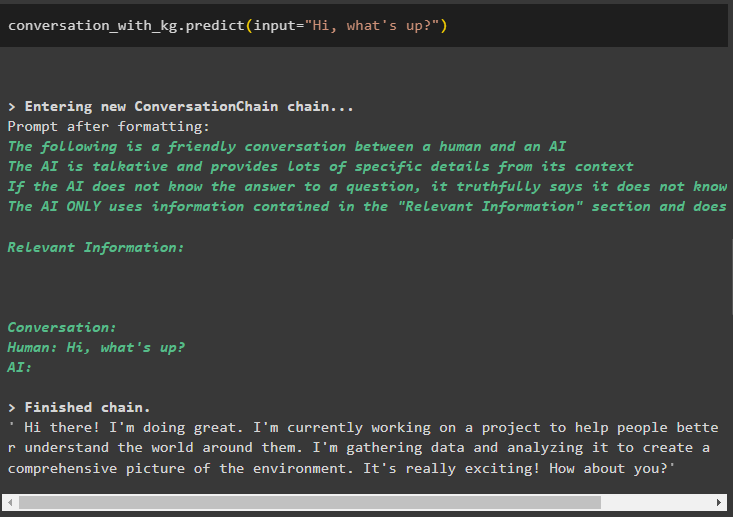

Depois que o modelo for criado, basta chamar o conversa_com_kg modelo usando o método predizer() com a consulta feita pelo usuário:

conversa_com_kg. prever ( entrada = 'Oi, e ai?' )

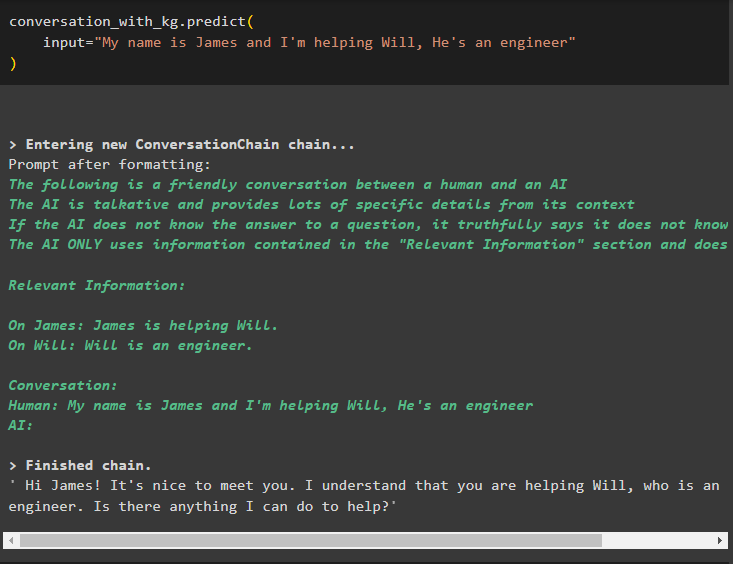

Agora, treine o modelo usando memória de conversação, fornecendo as informações como argumento de entrada para o método:

conversa_com_kg. prever (entrada = 'Meu nome é James e estou ajudando Will, ele é engenheiro'

)

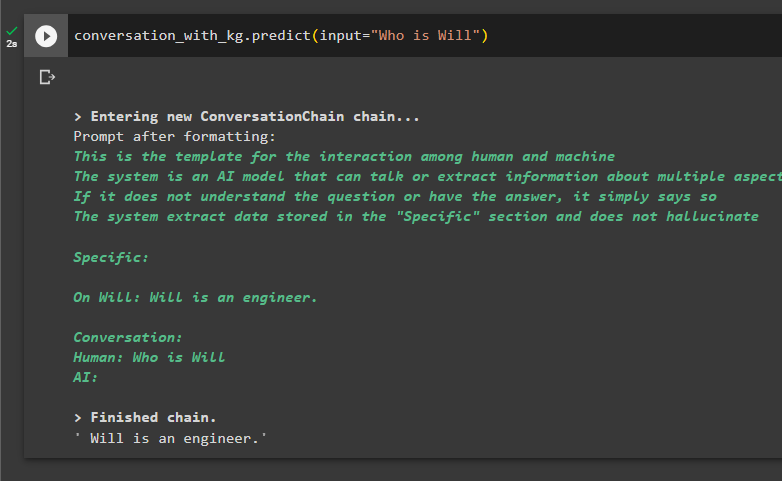

Este é o momento de testar o modelo, solicitando às consultas que extraiam informações dos dados:

conversa_com_kg. prever ( entrada = 'Quem é Vontade' )

Trata-se de usar o gráfico de conhecimento de conversação no LangChain.

Conclusão

Para usar o gráfico de conhecimento de conversação em LangChain, instale os módulos ou estruturas para importar bibliotecas para usar o método ConversationKGMemory(). Em seguida, construa o modelo utilizando a memória para construir as cadeias e extrair informações dos dados de treinamento fornecidos na configuração. Este guia elaborou o processo de uso do gráfico de conhecimento de conversação no LangChain.