Este guia ilustrará o processo de execução de LLMChains em LangChain.

Como executar LLMChains em LangChain?

LangChain fornece os recursos ou dependências para construir LLMChains usando LLMs/Chatbots e modelos de prompt. Para aprender o processo de construção e execução de LLMChains em LangChain, basta seguir o seguinte guia passo a passo:

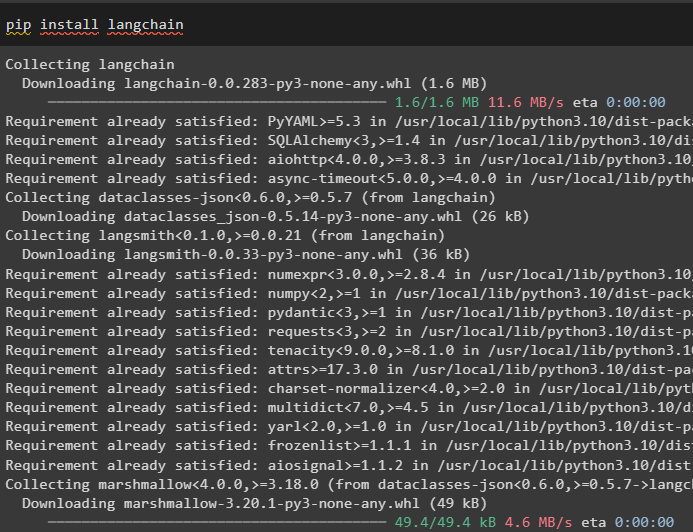

Etapa 1: instalar pacotes

Primeiro, comece o processo instalando o módulo LangChain para obter suas dependências para construir e executar LLMChains:

pip instalar langchain

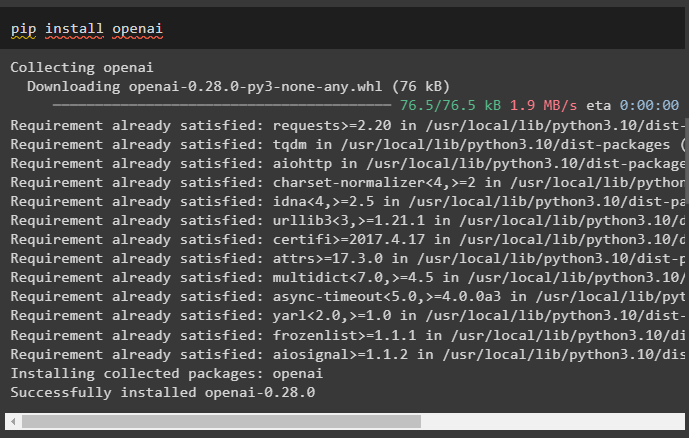

Instale a estrutura OpenAI usando o comando pip para fazer com que as bibliotecas usem a função OpenAI() para construir LLMs:

pip instalar openai

Após a instalação dos módulos, basta configurar o ambiente variáveis usando a chave API da conta OpenAI:

importar os

importar Obter passagem

os . aproximadamente [ 'OPENAI_API_KEY' ] = Obter passagem . Obter passagem ( 'Chave de API OpenAI:' )

Etapa 2: importar bibliotecas

Assim que a configuração for concluída e todos os pacotes necessários instalados, importe as bibliotecas necessárias para construir o modelo de prompt. Depois disso, basta construir o LLM usando o método OpenAI() e configurar o LLMChain usando os LLMs e o modelo de prompt:

de cadeia de idiomas importar Modelo de promptde cadeia de idiomas importar OpenAI

de cadeia de idiomas importar LLMChain

prompt_template = 'dê-me um bom título para o negócio que produz {produto}?'

llm = OpenAI ( temperatura = 0 )

llm_chain = LLMChain (

llm = llm ,

incitar = PromptTemplate. Do modelo ( prompt_template )

)

llm_chain ( 'Roupas coloridas' )

Etapa 3: correntes em execução

Obtenha a lista de entrada contendo diversos produtos produzidos pela empresa e execute a cadeia para exibir a lista na tela:

lista_de_entrada = [{ 'produtos' : 'meias' } ,

{ 'produtos' : 'computador' } ,

{ 'produtos' : 'sapato' }

]

llm_chain. aplicar ( lista_de_entrada )

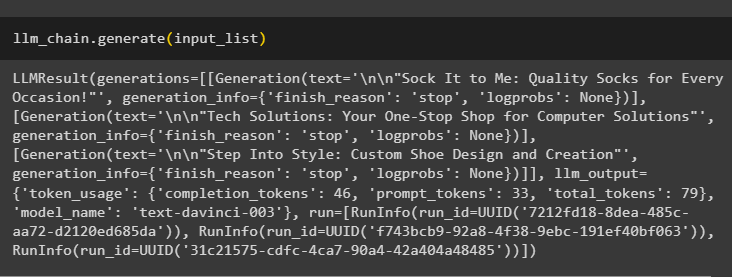

Execute o método generate() usando o lista_de_entrada com LLMChains para obter a saída relacionada à conversa gerada pelo modelo:

llm_chain. gerar ( lista_de_entrada )

Etapa 4: usando entrada única

Adicione outro produto para executar o LLMChains usando apenas uma única entrada e, em seguida, preveja o LLMChain para gerar a saída:

llm_chain. prever ( produtos = 'meias coloridas' )Etapa 5: usando múltiplas entradas

Agora, construa o modelo para usar múltiplas entradas para fornecer o comando ao modelo antes de executar a cadeia:

modelo = '''Conte-me uma piada de {adjetivo} sobre {assunto}.'''incitar = Modelo de prompt ( modelo = modelo , variáveis_de_entrada = [ 'adjetivo' , 'assunto' ] )

llm_chain = LLMChain ( incitar = incitar , llm = OpenAI ( temperatura = 0 ) )

llm_chain. prever ( adjetivo = 'triste' , assunto = 'patos' )

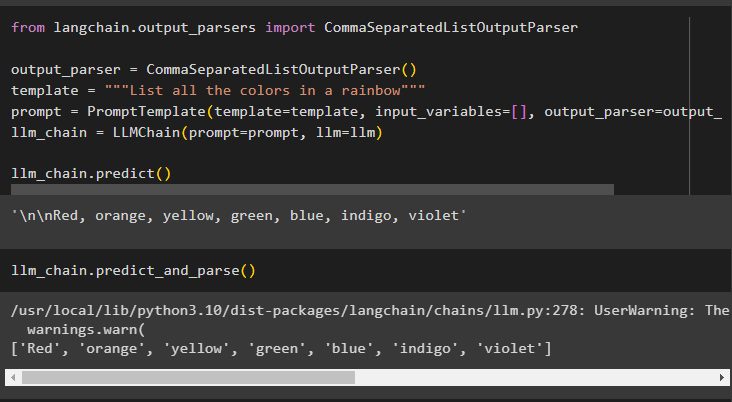

Etapa 6: usando o analisador de saída

Esta etapa usa o método analisador de saída para executar o LLMChain para obter a saída com base no prompt:

de cadeia longa. analisadores de saída importar CommaSeparatedListOutputParseranalisador de saída = CommaSeparatedListOutputParser ( )

modelo = '''Liste todas as cores de um arco-íris'''

incitar = Modelo de prompt ( modelo = modelo , variáveis_de_entrada = [ ] , analisador de saída = analisador de saída )

llm_chain = LLMChain ( incitar = incitar , llm = llm )

llm_chain. prever ( )

Usar o método parse() para obter a saída gerará uma lista separada por vírgulas de todas as cores do arco-íris:

llm_chain. prever_e_parse ( )

Etapa 7: inicializando a partir de strings

Esta etapa explica o processo de uso de uma string como prompt para executar o LLMChain usando o modelo e modelo LLM:

modelo = '''Conte-me uma piada de {adjetivo} sobre {assunto}'''llm_chain = LLMChain. de_string ( llm = llm , modelo = modelo )

Forneça os valores das variáveis no prompt de string para obter a saída do modelo executando LLMChain:

llm_chain. prever ( adjetivo = 'triste' , assunto = 'patos' )Trata-se de executar o LLMChains usando a estrutura LangChain.

Conclusão

Para construir e executar LLMChains em LangChain, instale os pré-requisitos como pacotes e configure o ambiente usando a chave API do OpenAI. Depois disso, importe as bibliotecas necessárias para configurar o modelo de prompt e o modelo para executar o LLMChain usando as dependências do LangChain. O usuário pode usar analisadores de saída e comandos de string para executar LLMChains conforme demonstrado no guia. Este guia elaborou o processo completo de execução do LLMChains no LangChain.