Limpando os dados com Python e Pandas

Os dados são como os blocos de construção da tomada de decisões hoje. Mas imagine ter um grupo de blocos de diferentes formatos e tamanhos desta coleção; é difícil construir algo significativo. É aqui que a limpeza de dados entra para ajudar.

Este guia explora como limpar os dados usando a estrutura do Python, que é o Pandas, para uma melhor tomada de decisões. A limpeza dos dados também é fundamental, visto que estamos trabalhando com uma lista de registros de vendas de uma loja. Podemos notar alguns números faltantes, datas estranhas e itens repetidos sem motivo na lista. Se fizermos cálculos ou registros com base nessas informações, essas questões podem atrapalhar nossos cálculos e previsões. A limpeza de dados ajuda a resolver esses problemas, garantindo que nossos dados sejam precisos e prontos para uso.

A limpeza de dados inclui lidar com os dados ausentes e o que fazer quando alguns dados estão faltando, remover as duplicatas, livrar-se de coisas copiadas, corrigir os tipos de dados, garantir que tudo esteja no formato adequado e lidar com valores discrepantes ou manipular os números que não se encaixam. Esses erros fazem com que os dados pareçam iguais e padronizam a forma como os dados aparecem.

Para começar, certifique-se primeiro de ter o Python e o Pandas instalados. Podemos fazer isso digitando os comandos no terminal ou prompt de comando do nosso computador. Para implementar os códigos mencionados neste guia, podemos usar o Python Pycharm IDE que está instalado em nosso sistema ou a plataforma online Python que é “Google Colab” e instalar os comandos “pip” para instalar as bibliotecas importantes.

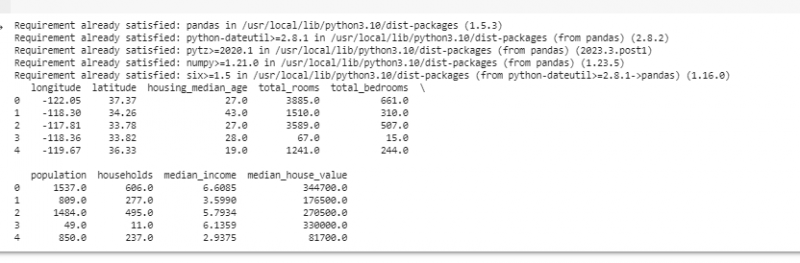

Agora, vamos importar o Pandas e carregar nossos dados de amostra. Neste exemplo, usamos o Google Colab para executar os códigos. Portanto, primeiro importamos o Pandas digitando o seguinte comando:

! pip instalar pandas

importar pandas como PD

importar entorpecido como por exemplo.

Em seguida, carregamos o conjunto de dados que queremos exibir usando o método pd.read() que toma o caminho do arquivo como parâmetro de entrada.

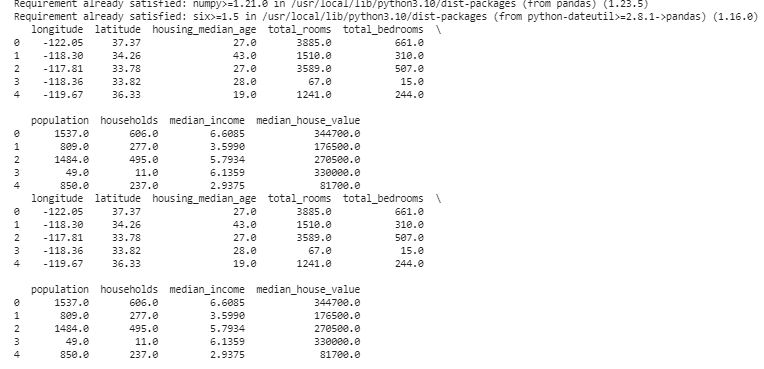

# Carrega o conjunto de dadosdados = pd. leitura_csv ( '/content/sample_data/california_housing_test.csv' )

#Exibe as primeiras linhas

imprimir ( dados. cabeça ( ) )

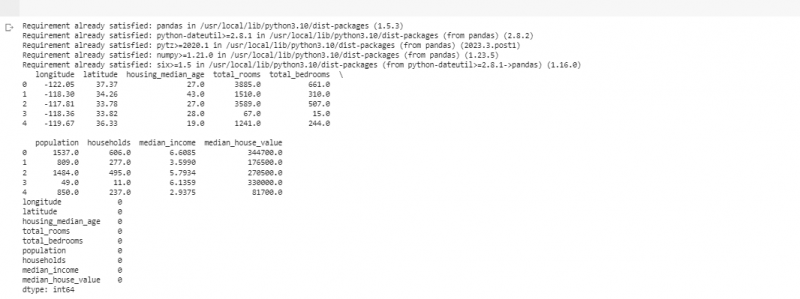

No próximo exemplo, usamos os dados sobre vendas em uma pequena loja. Para lidar com os dados ausentes, às vezes faltam informações em nossos dados. Chamamos essas partes faltantes de “NaN” (que significa “não é um número”). Para encontrar esses valores ausentes no script Python, primeiro carregamos o conjunto de dados como fizemos no exemplo anterior. Em seguida, encontramos quaisquer valores ausentes no conjunto de dados usando a função “missing_values = data.isnull().sum()”. Esta função encontra todos os valores ausentes no conjunto de dados. Em seguida, nós os exibimos usando a função print().

! pip instalar pandasimportar pandas como PD

importar entorpecido como por exemplo.

# Carrega o conjunto de dados

dados = pd. leitura_csv ( '/content/sample_data/california_housing_test.csv' )

#Exibe as primeiras linhas

imprimir ( dados. cabeça ( ) )

#Verifica se há valores faltantes

valores_ausentes = dados. é nulo ( ) . soma ( )

# Exibe a contagem de valores faltantes por coluna

imprimir ( valores_ausentes )

Depois de encontrarmos quaisquer dados ausentes em qualquer linha que executa o código mencionado anteriormente, podemos remover essas linhas, pois elas não contêm muitos dados úteis. Podemos até adivinhar esses valores ausentes e preencher as lacunas com suposições fundamentadas, estimando os dados baseados no tempo com base em pontos próximos.

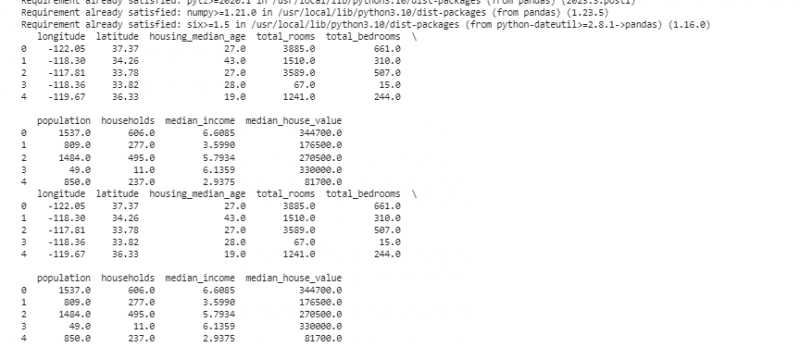

Agora, removemos as duplicatas que são cópias da mesma coisa porque podem confundir nossa análise. Para encontrar os valores duplicados no conjunto de dados, usamos a função “duplicate_rows = data[data.duplicated()]”. Para eliminar esses valores duplicados, chamamos a função data.drop_duplicates(). Podemos localizá-los e removê-los usando o seguinte código:

! pip instalar pandasimportar pandas como PD

importar entorpecido como por exemplo.

# Carrega o conjunto de dados

dados = pd. leitura_csv ( '/content/sample_data/california_housing_test.csv' )

#Exibe as primeiras linhas

imprimir ( dados. cabeça ( ) )

#Verifica se há linhas duplicadas

linhas_duplicadas = dados [ dados. duplicado ( ) ]

#Remover duplicatas

dados = dados. drop_duplicados ( )

# Exibe as primeiras linhas após remover duplicatas

imprimir ( dados. cabeça ( ) )

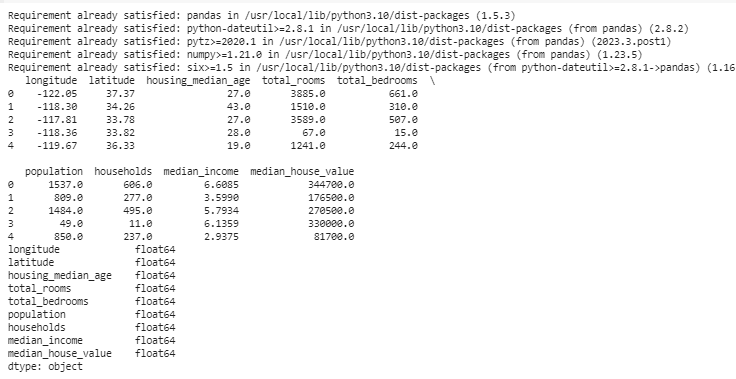

Os tipos de dados decidem quais dados podem ser armazenados para corrigir os tipos de dados. É essencial ter o tipo certo para cada tipo de dado. Por exemplo, as datas devem ter o tipo de dados data e hora e os números devem estar no tipo de dados como int, float, etc. Para verificar os tipos de dados de nossos dados, usamos a função “data.dtypes”. Esta função pode ser utilizada da seguinte maneira:

! pip instalar pandasimportar pandas como PD

importar entorpecido como por exemplo.

# Carrega o conjunto de dados

dados = pd. leitura_csv ( '/content/sample_data/california_housing_test.csv' )

#Exibe as primeiras linhas

imprimir ( dados. cabeça ( ) )

# Verifique os tipos de dados de cada coluna

tipos de dados = dados. dtypes

#Exibir tipos de dados

imprimir ( tipos de dados )

Se encontrarmos algum problema, podemos alterar o tipo de dados usando Pandas. Por exemplo, podemos transformar datas em um formato de data. O atributo “dtypes” de um DataFrame fornece informações sobre os tipos de dados de cada coluna. Se descobrirmos que os tipos de dados são incompatíveis, podemos usar a função astype() do Pandas para converter as colunas nos tipos desejados.

Após os tipos de dados, às vezes encontramos outliers que são valores muito diferentes dos demais. Eles podem atrapalhar nossos cálculos. Para lidar com outliers, definimos uma função que usa a função z-score “np.abs(stats.zscore(data))” que compara os valores que existem em nossos dados com o valor limite. Qualquer valor diferente do intervalo deste limite é considerado um valor discrepante . Vamos ver como encontrar e lidar com os outliers:

! pip instalar pandasimportar pandas como PD

importar entorpecido como por exemplo.

# Carrega o conjunto de dados

dados = pd. leitura_csv ( '/content/sample_data/california_housing_test.csv' )

#Exibe as primeiras linhas

imprimir ( dados. cabeça ( ) )

de picante importar Estatísticas

definição detectar_outliers ( dados ) :

z_pontuações = por exemplo. abdômen ( Estatísticas. pontuação z ( dados ) )

retornar por exemplo. onde ( z_pontuações > 3 )

# Detectar e tratar valores discrepantes na coluna 'Vendas'

valores discrepantes = detectar_outliers ( dados [ 'longitude' ] )

dados [ 'longitude' ] . lugar [ valores discrepantes ] = dados [ 'longitude' ] . mediana ( )

# Detectar e tratar valores discrepantes na coluna 'Unidades Vendidas'

valores discrepantes = detectar_outliers ( dados [ 'latitude' ] )

dados [ 'latitude' ] . lugar [ valores discrepantes ] = dados [ 'latitude' ] . mediana ( )

# Exibe as primeiras linhas após lidar com valores discrepantes

imprimir ( dados. cabeça ( ) )

Usamos um método simples para encontrar e corrigir os valores discrepantes no código anterior. Envolve substituir os valores extremos pelo valor médio dos dados. Este código usa o método Z-score para detectar valores discrepantes nas colunas “longitude” e “latitude” do nosso conjunto de dados. Os outliers são substituídos pelos valores medianos de suas respectivas colunas.

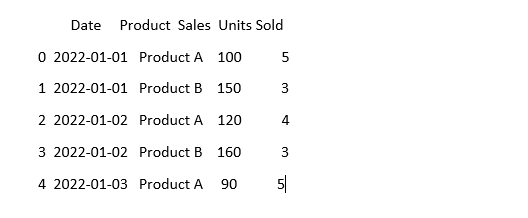

Para fazer com que os dados pareçam iguais, às vezes eles podem parecer diferentes, mesmo que signifiquem a mesma coisa. Por exemplo, as datas podem ser escritas em vários formatos. A padronização envolve garantir um formato e representação de dados consistentes. Isso pode incluir a formatação das datas, a conversão do texto para letras minúsculas ou a normalização dos valores numéricos. Vamos padronizar a coluna “Data” em nosso conjunto de dados e garantir que nossos dados tenham a mesma aparência:

importar pandas como PDimportar entorpecido como por exemplo. #Importar numpy

#Carrega os dados

dados = pd. leitura_csv ( 'dados_vendas.csv' )

# Faça com que a coluna 'Data' pareça consistente

dados [ 'Data' ] = pd. até_datahora ( dados [ 'Data' ] )

# Veja como está agora

imprimir ( dados. cabeça ( ) )

Neste exemplo, padronizamos o formato de data em nosso conjunto de dados para o formato de data e hora do Python usando a função “pd.to_datetime(data['Date'])”. Ao converter a coluna “Data” para o mesmo formato, facilitamos o trabalho com esses dados. A saída exibe as primeiras linhas do conjunto de dados com a coluna “Data” padronizada.

Conclusão

Em nossa jornada pela limpeza de dados usando Python e Pandas, aprendemos como melhorar nossos dados para análise. Começamos entendendo porque a limpeza dos dados é tão importante. Isso nos ajuda a tomar melhores decisões. Exploramos como lidar com dados ausentes, remover duplicatas, corrigir tipos de dados, lidar com valores discrepantes e fazer com que nossos dados tenham a mesma aparência. Com essas habilidades, estamos mais bem preparados para transformar dados confusos em algo em que podemos confiar e usar para descobrir informações importantes. A limpeza de dados é um processo contínuo, como manter nosso quarto arrumado, e torna nossa jornada de análise de dados mais bem-sucedida.