Neste blog, vamos nos concentrar nas maneiras pelas quais você pode aumentar a utilização da GPU no PyTorch.

Como aumentar a utilização da GPU no PyTorch?

Existem diversas técnicas que podem ser empregadas para aumentar a utilização da GPU e garantir que os melhores recursos de hardware estejam sendo utilizados para o processamento de modelos complexos de aprendizado de máquina. Essas táticas envolvem a edição do código e a utilização dos recursos do PyTorch. Algumas dicas e truques importantes estão listados abaixo:

- Carregando dados e tamanhos de lote

- Modelos menos dependentes de memória

- Relâmpago PyTorch

- Ajustar as configurações de tempo de execução no Google Colab

- Limpe o cache para otimização

Carregando dados e tamanhos de lote

O ' Carregador de dados ”em PyTorch é usado para definir as especificações dos dados a serem carregados no processador com cada passagem direta do modelo de aprendizado profundo. Um maior ' tamanho do batch ”de dados exigirá mais poder de processamento e aumentará a utilização da GPU disponível.

A sintaxe para atribuir um Dataloader com um tamanho de lote específico no PyTorch a uma variável personalizada é fornecida abaixo:

Aumentar_GPU_Utilização = DataLoader ( tamanho do batch = 32 )

Modelos menos dependentes de memória

Cada arquitetura de modelo requer um volume diferente de “ memória ”Para ter um desempenho em seu nível ideal. Modelos eficientes no uso de menos memória por unidade de tempo são capazes de trabalhar com tamanhos de lote muito maiores que outros.

Relâmpago PyTorch

PyTorch tem uma versão reduzida que é “ Relâmpago PyTorch ”. Ele é otimizado para desempenho extremamente rápido, como pode ser visto em seu nome. O Lightning usa GPUs por padrão e oferece processamento muito mais rápido para modelos de aprendizado de máquina. Uma grande vantagem do Lightning é a falta de exigência de código padrão que pode dificultar o processamento.

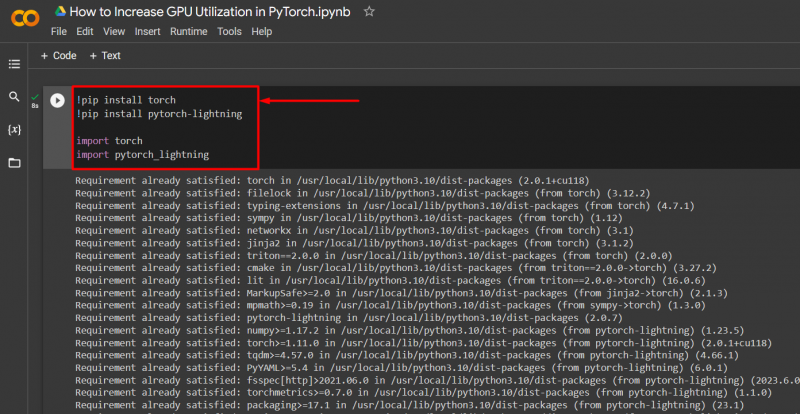

Importe as bibliotecas necessárias para um projeto PyTorch com a sintaxe fornecida abaixo:

! pip instalar tocha

! pip instalar pytorch - raio

importar tocha

importar pytorch_lightning

Ajustar as configurações de tempo de execução no Google Colab

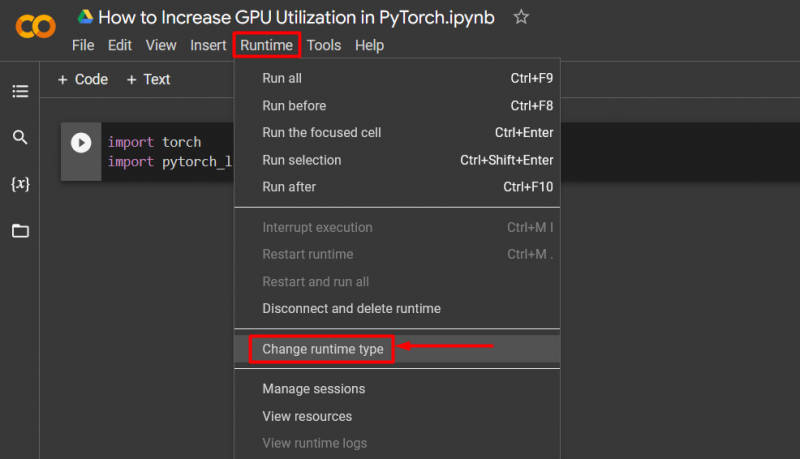

O Google Colaboratory é um IDE em nuvem que fornece acesso gratuito à GPU aos seus usuários para o desenvolvimento de modelos PyTorch. Por padrão, os projetos do Colab são executados na CPU, mas as configurações podem ser alteradas.

Abra o notebook Colab, vá para “ Tempo de execução ”Opção na barra de menu e role para baixo até a opção“ Alterar configurações de tempo de execução ”:

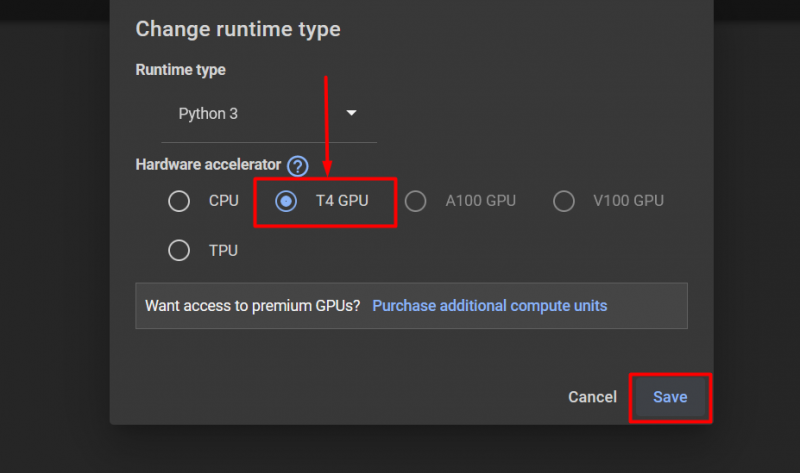

Em seguida, selecione o “GPU T4” opção e clique em “ Salvar ”Para aplicar as alterações para utilizar GPU:

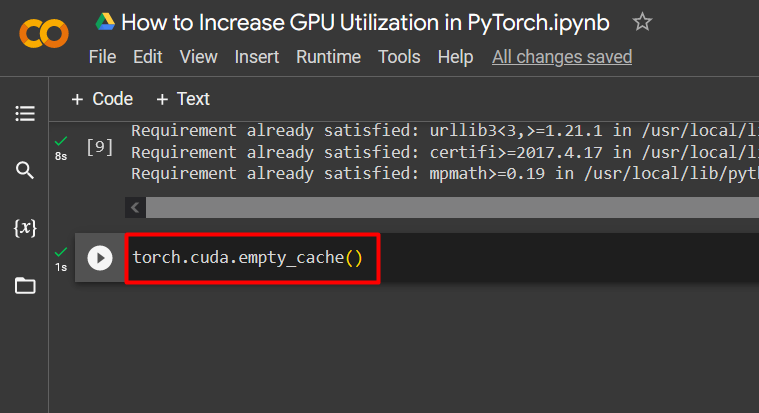

Limpe o cache para otimização

PyTorch permite que seus usuários limpem o cache de memória para poder liberar espaço para a execução de novos processos. O ' Cache ” armazena dados e informações sobre os modelos em execução para economizar tempo que será gasto no recarregamento desses modelos. A limpeza do cache fornece aos usuários mais espaço para executar novos modelos.

O comando para limpar o cache da GPU é fornecido abaixo:

tocha. diferente . cache_vazio ( )

Essas dicas são usadas para otimizar a execução de modelos de aprendizado de máquina com GPUs no PyTorch.

Dica profissional

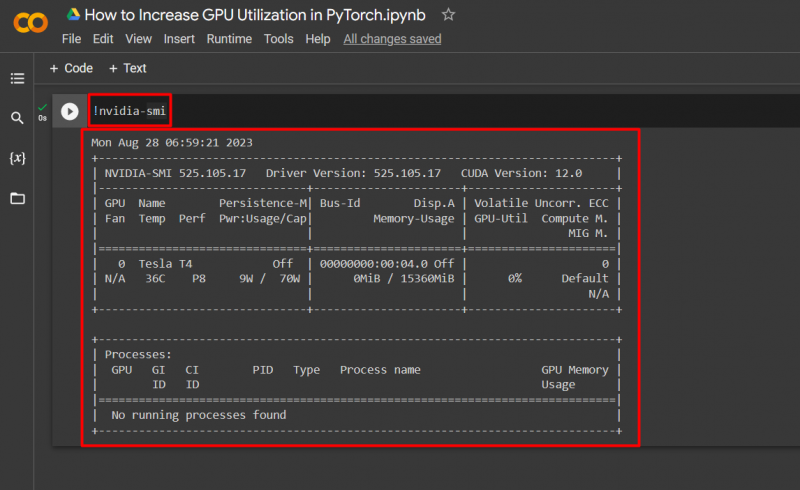

O Google Colab permite que seus usuários acessem detalhes sobre a utilização da GPU por “ nvidia ”Para obter informações sobre onde os recursos de hardware estão sendo utilizados. O comando para mostrar os detalhes de utilização da GPU é fornecido abaixo:

! nvidia - sorri

Sucesso! Acabamos de demonstrar algumas maneiras de aumentar a utilização da GPU no PyTorch.

Conclusão

Aumente a utilização da GPU no PyTorch excluindo o cache, usando o PyTorch Lightning, ajustando as configurações de tempo de execução, usando modelos eficientes e tamanhos de lote ideais. Essas técnicas ajudam muito a garantir que os modelos de aprendizagem profunda tenham o melhor desempenho e sejam capazes de tirar conclusões e inferências válidas a partir dos dados disponíveis. Demonstramos as técnicas para aumentar a utilização da GPU.