A função pipeline() é parte integrante da biblioteca Transformer. São necessárias várias entradas nas quais podemos definir uma tarefa de inferência, modelos, mecanismo de tokenização, etc. Uma função pipeline() é usada principalmente para realizar tarefas de PNL em um ou vários textos. Ele executa o pré-processamento na entrada e o pós-processamento com base no modelo para gerar uma saída legível por humanos e uma previsão precisa com a máxima precisão.

Este artigo cobre os seguintes aspectos:

- O que é a biblioteca de conjuntos de dados Hugging Face?

- Como aplicar pipelines em um conjunto de dados no Hugging Face?

O que é a biblioteca do conjunto de dados Hugging Face?

Uma biblioteca de conjuntos de dados Hugging Face é uma API que contém vários conjuntos de dados públicos e fornece uma maneira fácil de baixá-los. Esta biblioteca pode ser importada e instalada no aplicativo usando o “ pip ” comando. Para uma demonstração prática para baixar e instalar conjuntos de dados da biblioteca Hugging Face, visite este Link do Google Colab. Você pode baixar vários conjuntos de dados do Abraçando o Hub do conjunto de dados faciais.

Saiba mais sobre o funcionamento da função pipeline() consultando este artigo “ Como utilizar a função Pipeline() em transformadores? ”.

Como aplicar pipelines em um conjunto de dados no Hugging Face?

Hugging Face fornece vários conjuntos de dados públicos diferentes que podem ser facilmente instalados usando código de uma linha. Neste artigo, veremos uma demonstração prática da aplicação de pipelines a esses conjuntos de dados. Existem duas maneiras pelas quais os pipelines podem ser implementados no conjunto de dados.

Método 1: usando o método de iteração

A função pipeline() também pode ser iterada em um conjunto de dados e modelo. Para tanto, siga as etapas abaixo mencionadas:

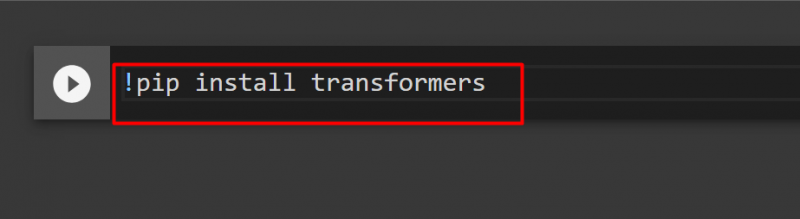

Etapa 1: instalar a biblioteca do Transformer

Para instalar a biblioteca Transformer, forneça o seguinte comando:

!pip instalar transformadores

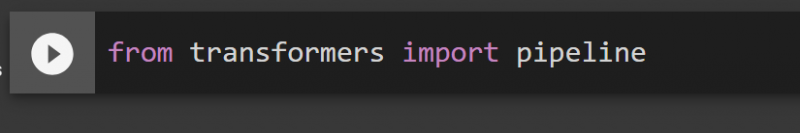

Etapa 2: importar pipelines

Podemos importar o pipeline da biblioteca Transformer. Para isso, forneça o seguinte comando:

do pipeline de importação de transformadores

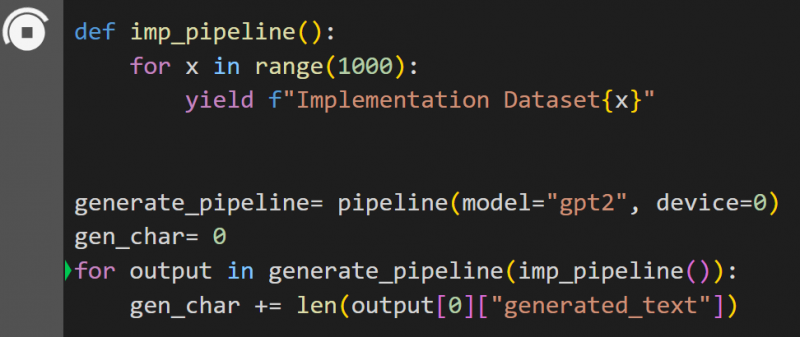

Etapa 3: implementar o pipeline

Aqui, a função pipeline() é implementada no modelo “ gpt2 ”. Você pode baixar modelos do Abraçando o Hub do Modelo de Rosto:

def imp_pipeline():para x no intervalo (1000):

rendimento f'Conjunto de dados de implementação{x}'

generate_pipeline= pipeline(model='gpt2', dispositivo=0)

gen_char = 0

para saída em generate_pipeline(imp_pipeline()):

gen_char += len(saída[0]['texto_gerado'])

Neste código, o “ gerar_pipeline ”é uma variável que contém a função pipeline() com modelo“ gpt2 ”. Quando é chamado com o “ imp_pipeline() ”Função, reconhece automaticamente os dados que são aumentados com o intervalo especificado para 1000:

Isso levará algum tempo para treinar. O link para o Google Co. também é dado.

Método 2: usando biblioteca de conjuntos de dados

Neste método, demonstraremos a implementação do pipeline usando a biblioteca “datasets”:

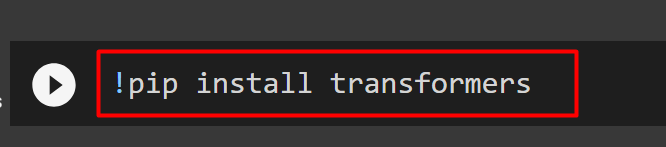

Etapa 1: instalar o transformador

Para instalar a biblioteca Transformer, forneça o seguinte comando:

!pip instalar transformadores

Etapa 2: instalar a biblioteca de conjuntos de dados

Enquanto o ' conjuntos de dados ”Contém todos os conjuntos de dados públicos, podemos instalá-lo usando o seguinte comando. Ao instalar o “ conjuntos de dados ”biblioteca, podemos importar diretamente qualquer conjunto de dados, fornecendo seu nome:

!pip instalar conjuntos de dados

Etapa 3: pipeline do conjunto de dados

Para construir um pipeline no conjunto de dados, use o código a seguir. KeyDataset é um recurso que gera apenas os valores que interessam ao usuário:

de transformers.pipelines.pt_utils importar KeyDatasetdo pipeline de importação de transformadores

de conjuntos de dados importar load_dataset

gen_pipeline = pipeline(model='hf-internal-testing/tiny-random-wav2vec2', dispositivo=0)

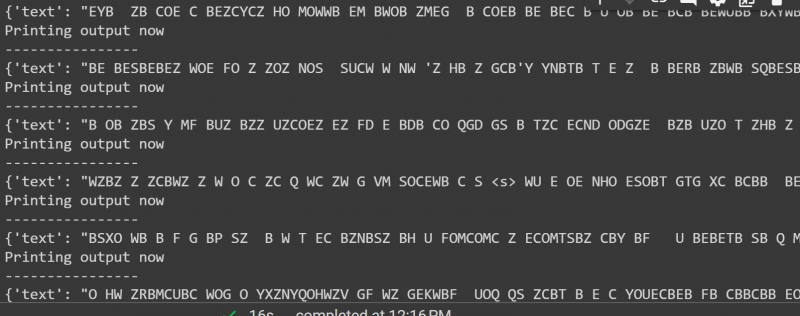

loaddataset = load_dataset('hf-internal-testing/librispeech_asr_dummy', 'clean', split='validation[:10]')para saída em gen_pipeline(KeyDataset(loaddataset, 'audio')):

print('Imprimindo saída agora')

imprimir ('----------------')

imprimir (saída)

A saída do código acima é fornecida abaixo:

Isso é tudo deste guia. O link para o Google Co. também é mencionado neste artigo

Conclusão

Para aplicar pipelines no conjunto de dados, podemos iterar sobre um conjunto de dados usando uma função pipeline() ou usar o “ conjuntos de dados ' biblioteca. Hugging Face fornece o link do repositório GitHub para seus usuários para conjuntos de dados e modelos que podem ser usados com base nos requisitos. Este artigo forneceu um guia completo para aplicar pipelines em um conjunto de dados em Transformers.